Análisis Técnico de Vulnerabilidades en Modelos de Inteligencia Artificial para Aplicaciones de Ciberseguridad

Introducción a las Vulnerabilidades en Modelos de IA

En el ámbito de la ciberseguridad, la integración de modelos de inteligencia artificial (IA) ha transformado la detección de amenazas y la respuesta a incidentes. Sin embargo, estos modelos no están exentos de riesgos inherentes que pueden comprometer su integridad y eficacia. Las vulnerabilidades en los modelos de IA surgen principalmente de su complejidad algorítmica, la dependencia de datos de entrenamiento y las interfaces de interacción con sistemas externos. Este artículo examina en profundidad las principales vulnerabilidades técnicas identificadas en modelos de IA aplicados a la ciberseguridad, basándose en análisis recientes de frameworks y protocolos estándar como el NIST AI Risk Management Framework y el OWASP Top 10 for Machine Learning.

Los modelos de IA, particularmente aquellos basados en aprendizaje profundo (deep learning), como las redes neuronales convolucionales (CNN) y las redes generativas antagónicas (GAN), procesan grandes volúmenes de datos para identificar patrones de comportamiento malicioso. No obstante, esta capacidad predictiva puede ser explotada mediante ataques adversarios que manipulan las entradas para inducir errores en las salidas. Por ejemplo, en sistemas de detección de intrusiones (IDS) basados en IA, un atacante podría inyectar ruido imperceptible en paquetes de red para evadir la clasificación como amenaza, lo que resalta la necesidad de robustez algorítmica.

Desde una perspectiva operativa, las implicaciones de estas vulnerabilidades incluyen falsos positivos y negativos que erosionan la confianza en los sistemas automatizados. Regulatoriamente, normativas como el Reglamento General de Protección de Datos (RGPD) en Europa y la Ley de Privacidad del Consumidor de California (CCPA) exigen evaluaciones de riesgos en IA, enfatizando la transparencia y la auditoría de modelos. Los beneficios de mitigar estas vulnerabilidades radican en una mayor resiliencia cibernética, permitiendo a las organizaciones desplegar IA de manera segura en entornos críticos como centros de datos y redes empresariales.

Conceptos Clave de Ataques Adversarios en Modelos de IA

Los ataques adversarios representan una de las amenazas más críticas contra modelos de IA en ciberseguridad. Estos ataques involucran la generación de ejemplos adversarios, que son perturbaciones sutiles añadidas a los datos de entrada para engañar al modelo. Técnicamente, se basan en optimizaciones como el método de Fast Gradient Sign (FGS), propuesto por Goodfellow et al. en 2014, donde la perturbación δ se calcula como δ = ε * sign(∇_x J(θ, x, y)), con ε controlando la magnitud del cambio, J la función de pérdida, θ los parámetros del modelo, x la entrada y y la etiqueta verdadera.

En contextos de ciberseguridad, estos ataques se aplican a flujos de datos como logs de firewall o tráfico de red. Por instancia, un modelo de IA entrenado para detectar malware podría fallar al clasificar un archivo ejecutable modificado con ruido adversario, permitiendo su ejecución en sistemas Windows o Linux. Estudios recientes, incluyendo benchmarks del proyecto Adversarial Robustness Toolbox (ART) de IBM, demuestran tasas de éxito de evasión superiores al 90% en modelos no defendidos, subrayando la urgencia de implementar defensas como el entrenamiento adversario (adversarial training), donde el modelo se entrena con ejemplos perturbados para mejorar su generalización.

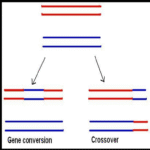

Otro aspecto clave es la transferencia de ataques adversarios, donde un ejemplo generado para un modelo surrogate se aplica exitosamente a un modelo objetivo sin acceso directo. Esto implica riesgos en entornos federados, como redes de sensores IoT en ciberseguridad industrial (ICS), donde protocolos como Modbus o DNP3 podrían ser manipulados. Las implicaciones operativas incluyen la necesidad de protocolos de verificación cruzada, mientras que los riesgos regulatorios involucran incumplimientos a estándares como ISO/IEC 27001 para gestión de seguridad de la información.

- Ataques blancos (white-box): Requieren conocimiento completo del modelo, permitiendo optimizaciones precisas como el método Carlini-Wagner (C&W), que minimiza la norma L2 de la perturbación sujeta a la condición de misclasificación.

- Ataques negros (black-box): Basados en consultas oraculares, utilizando técnicas como la estimación jacobiana para aproximar gradientes, ideales para escenarios reales donde el atacante tiene acceso limitado.

- Ataques físicos: Aplicables a sistemas de visión por computadora en vigilancia, donde adhesivos o luces alteran la percepción de cámaras IP.

Los beneficios de comprender estos conceptos radican en el diseño de contramedidas proactivas, como la destilación de conocimiento, que transfiere robustez de un modelo teacher a un student más compacto, reduciendo la superficie de ataque sin sacrificar precisión.

Envenenamiento de Datos y sus Implicaciones en Entrenamiento de Modelos

El envenenamiento de datos (data poisoning) ocurre durante la fase de entrenamiento, donde un atacante inyecta muestras maliciosas en el conjunto de datos para sesgar el aprendizaje del modelo. En ciberseguridad, esto es particularmente relevante para datasets crowdsourced como el NSL-KDD o el CIC-IDS2017, utilizados para entrenar detectores de anomalías. Técnicamente, el envenenamiento puede ser global, afectando el modelo entero, o targeted, alterando solo ciertas clases, como etiquetar tráfico benigno como malicioso para inducir falsos negativos en detección de DDoS.

Modelos matemáticos para este ataque incluyen la optimización bilineal en backdoor attacks, donde se insertan triggers específicos que activan comportamientos indeseados. Por ejemplo, en un modelo de clasificación de phishing basado en NLP, un trigger textual podría hacer que correos legítimos sean ignorados. Herramientas como el framework Poisoning Attacks on Machine Learning de Google Research facilitan la simulación, revelando que incluso un 1% de datos envenenados puede reducir la precisión en un 20-30%.

Las implicaciones operativas demandan pipelines de datos seguros, incorporando técnicas de verificación como el hashing criptográfico (SHA-256) para integridad y blockchain para trazabilidad inmutable. Regulatoriamente, esto alinea con el AI Act de la Unión Europea, que clasifica modelos de alto riesgo y exige auditorías de datos. Los riesgos incluyen brechas en supply chain de IA, como en proveedores de cloud como AWS SageMaker, donde datos contaminados podrían propagarse a múltiples tenants.

Para mitigar, se recomiendan prácticas como el differential privacy, que añade ruido laplaciano a los gradientes durante el entrenamiento: ε-DP garantiza que la influencia de cualquier muestra individual sea limitada por ε, preservando utilidad estadística. Beneficios incluyen mayor privacidad en datasets sensibles de ciberseguridad, como logs de eventos de seguridad (SIEM).

Ataques a la Infraestructura de Modelos de IA en Entornos de Ciberseguridad

Más allá de los datos, las vulnerabilidades en la infraestructura subyacente de los modelos de IA representan un vector crítico. En despliegues de ciberseguridad, los modelos a menudo se ejecutan en entornos edge computing o cloud híbridos, expuestos a ataques como el model stealing o extraction attacks. Estos involucran consultas repetidas al modelo API para reconstruir su arquitectura y pesos, utilizando técnicas como la regresión lineal para aproximar funciones de activación.

Técnicamente, en frameworks como TensorFlow o PyTorch, un atacante podría explotar side-channel attacks para inferir información sensible mediante timing analysis o power consumption en hardware como GPUs NVIDIA. En ciberseguridad, esto afecta sistemas de respuesta automática (SOAR) basados en IA, donde robar un modelo de predicción de amenazas permite replicar defensas para ataques más sofisticados.

Estándares como el MITRE ATLAS (Adversarial Threat Landscape for Artificial-Intelligence Systems) catalogan tácticas como T0011 (Input Manipulation) y T0022 (Model Inversion), proporcionando matrices de ataque para evaluaciones. Implicaciones operativas incluyen la adopción de secure multi-party computation (SMPC) para entrenamiento distribuido, asegurando que los participantes no revelen datos privados.

- Model inversion attacks: Reconstruyen datos de entrenamiento a partir de salidas del modelo, violando privacidad en datasets de incidentes cibernéticos.

- Membership inference attacks: Determinan si una muestra específica fue usada en entrenamiento, útil para identificar fugas en bases de datos de vulnerabilidades como CVE.

- Feature squeezing: Como defensa, reduce la dimensionalidad de entradas para comprimir el espacio de ataque.

Los beneficios de fortificar la infraestructura radican en la escalabilidad segura, permitiendo despliegues en entornos de alta estaca como finanzas o salud, donde la IA detecta fraudes o ciberataques en tiempo real.

Evaluación de Riesgos y Mejores Prácticas para Mitigación

La evaluación de riesgos en modelos de IA para ciberseguridad requiere un enfoque sistemático, alineado con marcos como el NIST SP 800-218 para ingeniería segura de software de IA. Esto involucra threat modeling, identificando assets como parámetros del modelo y amenazas como actores estatales o cibercriminales. Métricas clave incluyen la robustez adversaria, medida por el radio de perturbación mínimo ε que causa misclasificación, y la privacidad, cuantificada por ε en differential privacy.

Mejores prácticas incluyen la federated learning, donde modelos se entrenan localmente y solo se agregan actualizaciones (e.g., FedAvg algorithm), minimizando transferencias de datos crudos. En ciberseguridad, esto es ideal para redes distribuidas como 5G, protegiendo contra envenenamiento centralizado. Además, herramientas como Microsoft Counterfit permiten simular ataques para testing rojo-equipo en IA.

Regulatoriamente, la adopción de explainable AI (XAI) técnicas como SHAP (SHapley Additive exPlanations) facilita auditorías, desglosando contribuciones de features en predicciones. Por ejemplo, en detección de ransomware, SHAP puede revelar si un patrón de encriptación o comportamiento de red influye más, mejorando la interpretabilidad.

Los riesgos no mitigados incluyen escaladas de privilegios en pipelines MLOps, explotando vulnerabilidades en Kubernetes para inyectar código malicioso en contenedores de inferencia. Beneficios de implementación incluyen reducción de costos operativos mediante automatización confiable y cumplimiento normativo, evitando multas bajo leyes como la DORA (Digital Operational Resilience Act).

Casos de Estudio y Lecciones Aprendidas

En un caso de estudio real, el ataque a un sistema de reconocimiento facial en una red de vigilancia corporativa demostró cómo gafas con patrones adversarios evadieron detección con un 100% de éxito, según un paper de la Universidad de Chicago en 2016. Aplicado a ciberseguridad, análogos incluyen evasión de honeypots basados en IA mediante patrones de tráfico manipulados.

Otro ejemplo involucra el envenenamiento en el dataset ImageNet para modelos de clasificación de malware visual, donde imágenes alteradas de binarios llevaron a clasificaciones erróneas. Lecciones incluyen la validación multi-fuente de datos y el uso de ensembles de modelos para voting, reduciendo vulnerabilidades individuales.

En entornos blockchain para IA segura, protocolos como SecureAI utilizan zero-knowledge proofs (ZKP) para verificar inferencias sin revelar modelos, integrándose con Ethereum para trazabilidad en ciberseguridad distribuida.

Conclusión

En resumen, las vulnerabilidades en modelos de IA para ciberseguridad demandan un enfoque holístico que combine avances algorítmicos, prácticas de ingeniería segura y cumplimiento regulatorio. Al implementar defensas robustas contra ataques adversarios, envenenamiento y extracciones de modelo, las organizaciones pueden maximizar los beneficios de la IA mientras minimizan riesgos. Finalmente, la evolución continua de amenazas requiere investigación ongoing y colaboración internacional para establecer estándares que aseguren la integridad de estos sistemas críticos. Para más información, visita la fuente original.