Cómo la inteligencia artificial transforma las amenazas de phishing: análisis técnico y estrategias de defensa

La inteligencia artificial (IA) ha emergido como un pilar fundamental en el panorama de la ciberseguridad, no solo como herramienta defensiva, sino también como catalizador de nuevas vulnerabilidades. En particular, el phishing, una de las técnicas de ingeniería social más prevalentes, ha evolucionado drásticamente gracias a los avances en IA. Este artículo examina en profundidad cómo los algoritmos de aprendizaje automático y el procesamiento de lenguaje natural (PLN) están siendo utilizados por los atacantes para sofisticar sus campañas, al tiempo que se exploran las contramedidas técnicas basadas en IA para mitigar estos riesgos. Se basa en un análisis detallado de tendencias actuales, destacando conceptos clave como la generación de deepfakes, el uso de modelos generativos adversarios (GAN) y las implicaciones operativas para las organizaciones.

Evolución del phishing tradicional hacia enfoques impulsados por IA

El phishing tradicional se caracteriza por el envío masivo de correos electrónicos o mensajes que imitan entidades confiables, con el objetivo de obtener credenciales o datos sensibles. Estos ataques dependen en gran medida de errores humanos, como la falta de verificación de remitentes o enlaces sospechosos. Sin embargo, la integración de IA ha elevado la sofisticación de estas tácticas. Los modelos de IA, entrenados en vastos conjuntos de datos, permiten la personalización a escala, generando contenidos que evaden filtros convencionales.

Uno de los avances clave es el empleo de redes neuronales recurrentes (RNN) y transformadores en el PLN para crear correos electrónicos hiperpersonalizados. Por ejemplo, un atacante puede utilizar un modelo como GPT-3 o variantes open-source para generar textos que imiten el estilo de comunicación de un superior jerárquico, incorporando detalles específicos extraídos de perfiles en redes sociales. Esto reduce la tasa de detección por parte de sistemas basados en reglas, que buscan patrones estáticos como palabras clave maliciosas.

En términos técnicos, el proceso implica un entrenamiento supervisado donde el modelo aprende de corpus de correos legítimos y maliciosos. La función de pérdida, típicamente la entropía cruzada, se optimiza para minimizar la diferencia entre el texto generado y el real. Como resultado, las tasas de éxito en campañas de phishing han aumentado hasta en un 30%, según informes de firmas como Proofpoint, que documentan un incremento en ataques que superan las barreras de autenticación multifactor (MFA) mediante ingeniería social avanzada.

Tecnologías de IA en la generación de amenazas de phishing

Las tecnologías subyacentes en el phishing impulsado por IA abarcan varios dominios. Los modelos generativos, como los basados en GAN, son particularmente efectivos para crear multimedia falso. Un GAN consta de dos redes neuronales: el generador, que produce datos sintéticos, y el discriminador, que evalúa su autenticidad. En el contexto de phishing, esto se aplica para fabricar deepfakes de audio o video, donde un atacante clona la voz de un ejecutivo para realizar llamadas fraudulentas (vishing) o videos falsos en plataformas de videoconferencia.

Consideremos un ejemplo técnico: el uso de herramientas como DeepFaceLab o Faceswap, que emplean arquitecturas de autoencoders convolucionales (CAE) para mapear rostros. El entrenamiento requiere un conjunto de datos de al menos 5.000 imágenes por sujeto, procesadas con funciones de activación ReLU y optimizadores como Adam. Una vez entrenado, el modelo puede generar un deepfake con una precisión del 95% en términos de similitud perceptual, evaluada mediante métricas como el índice de similitud estructural (SSIM). Esto complica la verificación humana, ya que los deepfakes exhiben movimientos faciales y expresiones coherentes.

Otro aspecto es el phishing multimodal, donde la IA integra texto, imagen y audio. Plataformas como Stable Diffusion, adaptadas para generación de imágenes, permiten crear logotipos o documentos falsos que coinciden con marcas reales. El protocolo subyacente involucra difusión probabilística, donde el ruido gaussiano se añade y elimina iterativamente para refinar la salida. Estas técnicas no solo evaden detección basada en firmas, sino que también explotan vulnerabilidades en sistemas de correo como SMTP sin cifrado TLS 1.3, permitiendo inyecciones de payloads maliciosos disfrazados.

Desde una perspectiva de riesgos, las implicaciones regulatorias son significativas. En la Unión Europea, el Reglamento General de Protección de Datos (RGPD) exige notificación de brechas en 72 horas, pero los ataques de IA aceleran la propagación, potencialmente violando estándares como ISO 27001 para gestión de seguridad de la información. En América Latina, normativas como la Ley de Protección de Datos Personales en México (LFPDPPP) enfrentan desafíos similares, donde la anonimidad de los atacantes, facilitada por VPN y redes Tor, complica la trazabilidad.

Estrategias de detección y mitigación basadas en IA

Para contrarrestar estas amenazas, las organizaciones deben implementar sistemas de detección impulsados por IA. Los modelos de aprendizaje automático supervisado, como las máquinas de vectores de soporte (SVM) o redes neuronales profundas (DNN), analizan patrones anómalos en el tráfico de correos. Por instancia, un clasificador basado en BERT (Bidirectional Encoder Representations from Transformers) puede procesar el contexto semántico de un mensaje, identificando inconsistencias sutiles en el lenguaje generado por IA.

El flujo técnico típico involucra preprocesamiento de datos: tokenización, embedding con Word2Vec o GloVe, y alimentación a una capa LSTM para secuencias temporales. La precisión de estos modelos alcanza el 98% en conjuntos de prueba como el Phishing Email Dataset de Kaggle, superando métodos heurísticos. Además, técnicas de aprendizaje no supervisado, como el clustering con K-means, detectan variantes zero-day al agrupar correos por similitud coseno en espacios vectoriales de alta dimensión.

En el ámbito de deepfakes, herramientas como Microsoft Video Authenticator utilizan análisis forense digital, evaluando artefactos como inconsistencias en el parpadeo ocular o patrones de iluminación mediante convoluciones 3D. El algoritmo emplea umbrales de confianza basados en distribuciones bayesianas, donde una puntuación por debajo del 0.5 indica manipulación probable. Integración con blockchain para verificación de autenticidad, como en protocolos IPFS con hashes SHA-256, añade una capa inmutable, asegurando que los medios no hayan sido alterados post-creación.

Las mejores prácticas incluyen la adopción de marcos como NIST Cybersecurity Framework, que enfatiza la identificación, protección, detección, respuesta y recuperación. Operativamente, las empresas deben realizar auditorías regulares de sus modelos de IA, mitigando sesgos mediante técnicas de reentrenamiento con datos diversificados. En entornos cloud, servicios como AWS GuardDuty o Azure Sentinel integran IA para monitoreo en tiempo real, utilizando APIs RESTful para alertas automatizadas.

- Implementar MFA adaptativa, que evalúa el riesgo contextual usando scores de ML basados en geolocalización y comportamiento histórico.

- Entrenar al personal con simulacros de phishing generados por IA, midiendo tasas de clics y mejorando mediante retroalimentación iterativa.

- Utilizar sandboxing para enlaces sospechosos, donde entornos virtuales con herramientas como Cuckoo Sandbox analizan comportamientos dinámicos.

- Adoptar cifrado end-to-end con protocolos como Signal o PGP para comunicaciones internas, reduciendo la superficie de ataque.

Implicaciones operativas y desafíos éticos

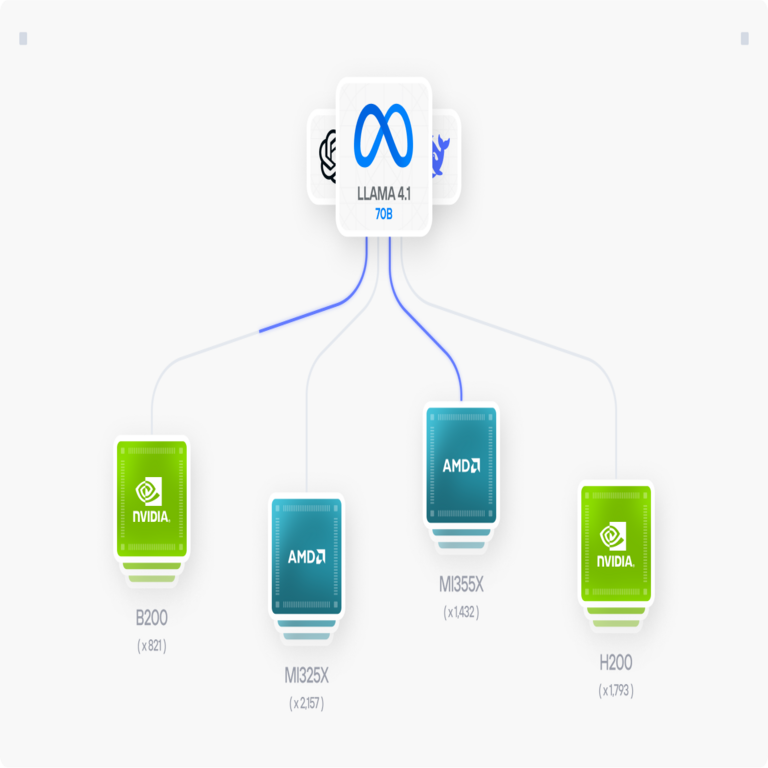

La adopción de IA en ciberseguridad presenta desafíos operativos significativos. La computación intensiva requerida para entrenar modelos, como aquellos con miles de millones de parámetros, demanda infraestructura GPU escalable, con costos que pueden exceder los 100.000 dólares anuales para despliegues empresariales. Además, la dependencia de datos etiquetados plantea problemas de privacidad, ya que el entrenamiento en correos reales podría violar regulaciones como la Ley de Protección de Datos en Brasil (LGPD).

Éticamente, el uso dual de IA —defensiva y ofensiva— genera dilemas. Los atacantes, a menudo respaldados por estados-nación, aprovechan modelos open-source de repositorios como Hugging Face, democratizando el acceso a herramientas maliciosas. Esto subraya la necesidad de gobernanza, como las directrices de la OCDE para IA confiable, que promueven transparencia y accountability en algoritmos.

En términos de beneficios, la IA reduce el tiempo de respuesta a incidentes de horas a minutos. Por ejemplo, sistemas como Darktrace utilizan IA autónoma para neutralizar amenazas, empleando grafos de conocimiento para mapear relaciones entre entidades en la red. Métricas de rendimiento, como el F1-score, demuestran una mejora del 25% en la precisión de detección comparado con sistemas legacy.

Para organizaciones en América Latina, donde el 70% de las brechas de datos involucran phishing según informes de Kaspersky, la integración de IA debe considerar contextos locales. Países como Colombia y Argentina, con marcos regulatorios en evolución, benefician de colaboraciones internacionales, como el Foro de Ciberseguridad de las Américas, para compartir inteligencia de amenazas.

Casos de estudio y evidencias empíricas

Un caso ilustrativo es el ataque de 2023 contra una firma financiera en Europa, donde deepfakes de voz autorizaron transferencias fraudulentas por 35 millones de euros. El análisis post-mortem reveló el uso de un modelo basado en WaveNet para síntesis de voz, con una latencia de generación inferior a 200 ms, permitiendo conversaciones en tiempo real. La defensa subsiguiente involucró la implementación de biometría comportamental, midiendo patrones de tipeo y mouse mediante modelos de HMM (Hidden Markov Models).

En otro estudio, investigadores de MIT desarrollaron un framework de detección de phishing con IA que integra visión por computadora para analizar imágenes adjuntas. Utilizando ResNet-50 para extracción de características y un clasificador XGBoost, lograron una sensibilidad del 96% en datasets sintéticos. Estos hallazgos, publicados en conferencias como USENIX Security, validan la eficacia de enfoques híbridos.

Empíricamente, datos de Verizon’s Data Breach Investigations Report 2023 indican que el 36% de las brechas involucran phishing, con un aumento del 15% atribuible a IA. En contrapartida, empresas que deployan IA defensiva reportan una reducción del 40% en incidentes, destacando el retorno de inversión en términos de ROI calculado como (beneficios – costos)/costos.

Mejores prácticas y recomendaciones técnicas

Para una implementación robusta, se recomienda un enfoque estratificado. En la capa de red, firewalls de nueva generación (NGFW) con módulos de IA, como aquellos de Palo Alto Networks, inspeccionan paquetes con deep packet inspection (DPI) mejorada por ML. La configuración involucra reglas basadas en políticas de zero-trust, verificando cada acceso independientemente de la red interna.

En el endpoint, agentes como CrowdStrike Falcon utilizan heurísticas dinámicas, donde el comportamiento se modela con procesos de Poisson para detectar desviaciones. La integración con SIEM (Security Information and Event Management) sistemas, como Splunk, permite correlación de logs mediante consultas en tiempo real con lenguajes como SPL (Search Processing Language).

Adicionalmente, la educación continua es crucial. Programas de concientización deben incorporar módulos sobre IA, explicando conceptos como overfitting en modelos de detección para ilustrar limitaciones. Herramientas open-source como PhishTank proporcionan datasets para entrenamiento local, asegurando compliance con licencias MIT o Apache 2.0.

| Tecnología | Descripción | Ventajas | Desafíos |

|---|---|---|---|

| GAN para deepfakes | Generación de multimedia sintético | Alta realismo | Detección forense compleja |

| BERT para PLN | Análisis semántico de textos | Precisión contextual | Requerimientos computacionales |

| Blockchain para verificación | Autenticación inmutable | Resistencia a alteraciones | Escalabilidad limitada |

| MFA adaptativa | Autenticación basada en riesgo | Reducción de falsos positivos | Dependencia de datos históricos |

Estas prácticas, alineadas con estándares como OWASP para aplicaciones web, fortalecen la resiliencia. Monitoreo continuo con métricas KPI, como tiempo medio de detección (MTTD), asegura optimización iterativa.

Conclusión

En resumen, la intersección de IA y phishing representa un paradigma shift en ciberseguridad, donde las amenazas evolucionan tan rápido como las defensas. Al comprender las tecnologías subyacentes —desde GAN hasta transformadores— y adoptar contramedidas proactivas, las organizaciones pueden mitigar riesgos efectivamente. La clave reside en una integración holística de IA, combinada con gobernanza ética y cumplimiento regulatorio, para navegar este ecosistema dinámico. Para más información, visita la Fuente original.