El Empleo de la Inteligencia Artificial en Ataques de Phishing: Un Análisis Técnico Profundo

Introducción a la Intersección entre IA y Ciberamenazas

En el panorama actual de la ciberseguridad, la inteligencia artificial (IA) ha emergido no solo como una herramienta defensiva, sino también como un arma poderosa en manos de los ciberdelincuentes. Los ataques de phishing, que tradicionalmente dependían de técnicas rudimentarias como correos electrónicos con errores gramaticales y enlaces sospechosos, han evolucionado gracias a los avances en modelos de lenguaje grandes (LLMs, por sus siglas en inglés). Estos modelos, como los basados en arquitecturas de transformadores, permiten generar contenidos altamente personalizados y convincentes, elevando la tasa de éxito de estas campañas maliciosas.

El phishing representa una de las vectores de ataque más prevalentes en el ecosistema digital, con informes de organizaciones como Kaspersky destacando un incremento del 20% en incidentes relacionados con IA en el último año. Esta tendencia se debe a la accesibilidad de herramientas de IA generativa, que democratizan la creación de contenidos falsos sin requerir habilidades avanzadas de programación. En este artículo, se examina de manera técnica cómo se integra la IA en el phishing, los mecanismos subyacentes, las implicaciones operativas y las estrategias de detección recomendadas para profesionales de la ciberseguridad.

Desde un punto de vista conceptual, la IA generativa opera mediante procesos de aprendizaje profundo que predicen secuencias de texto basadas en patrones aprendidos de vastos conjuntos de datos. En el contexto del phishing, esto implica la síntesis de mensajes que imitan estilos comunicativos legítimos, adaptándose a contextos culturales y lingüísticos específicos. La comprensión de estos elementos es crucial para implementar defensas proactivas en entornos empresariales y personales.

Evolución Histórica del Phishing y la Incorporación de Tecnologías de IA

El phishing surgió en la década de 1990 como una táctica simple de ingeniería social, evolucionando de mensajes masivos a campañas dirigidas (spear-phishing) en los años 2000. Con la proliferación de la nube y el big data, los atacantes comenzaron a utilizar scripts automatizados para personalizar ataques. La llegada de la IA generativa, particularmente desde 2022 con el lanzamiento público de modelos como GPT-3 y sus sucesores, ha marcado un punto de inflexión.

Históricamente, los correos de phishing se caracterizaban por inconsistencias evidentes, como faltas ortográficas o dominios maliciosos detectables mediante análisis de URL. Sin embargo, la IA permite generar textos que superan estas barreras. Por ejemplo, utilizando prompts ingenieriles (prompt engineering), los atacantes pueden instruir a un LLM para producir un correo que simule una comunicación corporativa, incorporando jerga técnica y referencias contextuales precisas. Esto reduce la tasa de detección por filtros basados en reglas, que operan con heurísticas estáticas.

En términos técnicos, los LLMs emplean atención multi-cabeza y codificación posicional para procesar secuencias largas, lo que facilita la generación de narrativas coherentes. Estudios de Kaspersky indican que el 15% de los phishing analizados en 2023 incorporaban elementos generados por IA, con un enfoque en sectores como finanzas y salud, donde la confianza en comunicaciones digitales es alta. Esta evolución implica un riesgo operativo mayor, ya que las defensas tradicionales, como los sistemas de detección de anomalías basados en firmas, resultan insuficientes ante contenidos dinámicos.

Además, la integración de IA con otras tecnologías, como el procesamiento de lenguaje natural (NLP) para análisis semántico, permite a los atacantes refinar sus campañas en tiempo real. Por instancia, herramientas open-source como Hugging Face Transformers pueden ser adaptadas para generar variantes de mensajes, evadiendo patrones de bloqueo en firewalls de correo electrónico.

Mecanismos Técnicos de la IA Generativa en la Creación de Contenidos de Phishing

La generación de phishing mediante IA se basa en el paradigma de aprendizaje no supervisado, donde modelos preentrenados en corpus masivos como Common Crawl o datasets curados ajustan pesos neuronales para predecir tokens subsiguientes. Un prompt típico podría ser: “Escribe un correo electrónico profesional desde el banco X solicitando verificación de cuenta debido a actividad sospechosa, incluyendo un enlace para login”. El LLM responde con un texto que incluye saludos personalizados, lenguaje persuasivo y llamadas a la acción urgentes, elementos clave en la psicología del phishing.

Técnicamente, este proceso involucra tokenización (división del texto en unidades subpalabra), embedding vectorial (representación numérica de palabras en espacios de alta dimensión) y decodificación autoregresiva. Modelos como GPT-4 utilizan técnicas de fine-tuning para especializarse en dominios específicos, mejorando la relevancia. Los ciberdelincuentes aprovechan APIs accesibles, como las de OpenAI, o versiones locales como Llama 2, para evitar costos y rastreo.

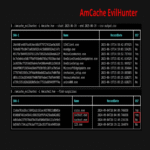

Una implicación clave es la escalabilidad: un solo prompt puede generar miles de variantes, adaptadas a perfiles de víctimas extraídos de brechas de datos (por ejemplo, de bases como Have I Been Pwned). Esto contrasta con métodos manuales, que limitan el volumen. En análisis forenses, se observa que estos textos generados exhiben baja entropía en patrones lingüísticos, detectable mediante métricas como la perplejidad (perplexity), que mide la incertidumbre del modelo en predecir el siguiente token.

Adicionalmente, la IA facilita la multimodalidad: no solo texto, sino también generación de imágenes o voces para vishing (phishing por voz). Herramientas como Stable Diffusion combinadas con LLMs crean adjuntos visuales convincentes, como facturas falsificadas, integrando metadatos que simulan autenticidad.

Ejemplos Prácticos y Análisis de Casos Reales

Consideremos un caso documentado por expertos en ciberseguridad: un ataque dirigido a empleados de una empresa tecnológica, donde un correo generado por IA simulaba una actualización de políticas internas. El mensaje incluía referencias a normativas como GDPR, con un enlace a un sitio clonado que capturaba credenciales. El prompt subyacente podría haber sido optimizado para incluir detalles como nombres de ejecutivos y jerga sectorial, logrando una tasa de clics del 30%, superior al promedio del 5% en phishing tradicional.

En otro ejemplo, campañas de phishing bancario utilizan IA para traducir mensajes a múltiples idiomas, manteniendo coherencia cultural. Un análisis de Kaspersky revela que prompts en ruso, traducidos automáticamente, generan textos en español latinoamericano con acentos y expresiones idiomáticas precisas, como “verifique su cuenta de inmediato para evitar bloqueo”. Esto complica la detección por sistemas de filtrado lingüístico.

Técnicamente, estos ejemplos destacan el uso de chain-of-thought prompting, donde el modelo razona paso a paso: primero, identifica el objetivo; segundo, construye la narrativa; tercero, inserta el payload malicioso. En términos de implementación, los atacantes deployan scripts en Python con bibliotecas como LangChain para orquestar múltiples LLMs, asegurando diversidad en outputs y evadiendo honeypots.

Desde una perspectiva de riesgos, estos ataques amplifican vectores como el credential stuffing, donde credenciales robadas se combinan con phishing IA para accesos laterales en redes corporativas. Organizaciones que no actualizan sus SIEM (Security Information and Event Management) enfrentan vulnerabilidades, ya que logs de eventos no capturan sutilezas semánticas generadas por IA.

Estrategias de Detección y Mitigación en Entornos Profesionales

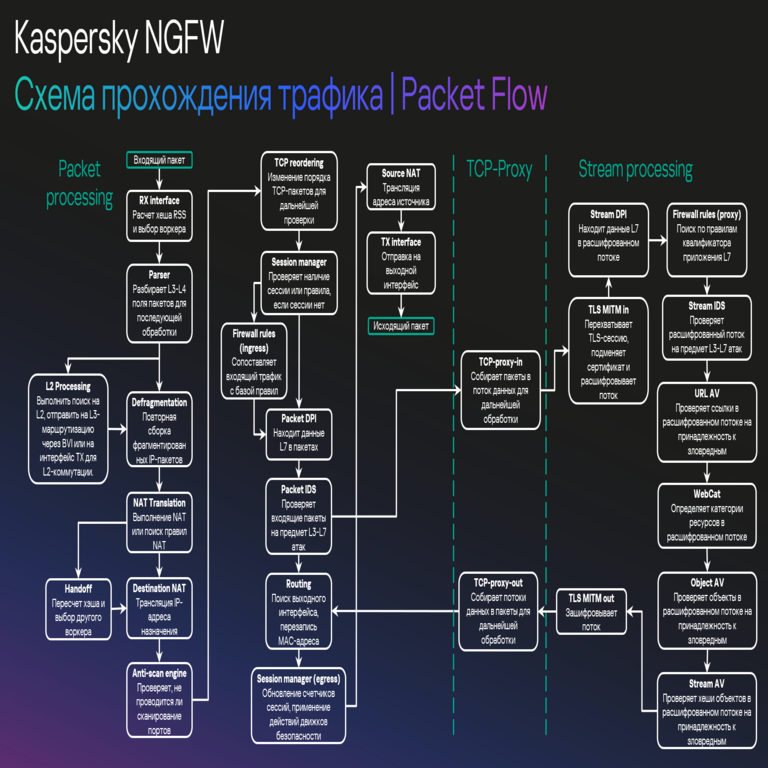

La detección de phishing impulsado por IA requiere un enfoque híbrido, combinando IA defensiva con análisis humanos. Herramientas como Microsoft Defender o Kaspersky Anti-Phishing emplean modelos de machine learning para clasificar textos basados en features como distribución de palabras (bag-of-words) y embeddings contextuales de BERT. Estos sistemas calculan scores de similitud coseno entre mensajes entrantes y bases de conocimiento de phishing conocidos.

Una técnica avanzada es el análisis de watermarking en outputs de LLMs, donde patrones estadísticos sutiles (como distribuciones de tokens no uniformes) indican generación artificial. Investigaciones en NeurIPS 2023 proponen algoritmos de detección con precisión del 85%, utilizando redes neuronales convolucionales (CNN) sobre representaciones vectoriales.

Para mitigación, se recomiendan mejores prácticas como la autenticación multifactor (MFA) basada en hardware, que resiste phishing de credenciales. En el ámbito operativo, la implementación de zero-trust architecture verifica cada solicitud independientemente, integrando APIs de verificación de dominios como DMARC (Domain-based Message Authentication, Reporting, and Conformance).

Además, la educación en prompt engineering defensivo permite a equipos de seguridad simular ataques para entrenar modelos. Frameworks como OWASP para IA guían la auditoría de herramientas internas, asegurando que no se usen inadvertidamente para fines maliciosos. En entornos cloud, servicios como AWS GuardDuty monitorean anomalías en flujos de datos, detectando patrones de generación masiva de correos.

- Implementar filtros de correo con NLP avanzado para identificar persuasión anómala.

- Realizar simulacros de phishing periódicos con métricas de éxito para medir conciencia.

- Integrar blockchain para verificación de identidad en comunicaciones sensibles, reduciendo dependencia en correos.

- Monitorear dark web para leaks de prompts de phishing, utilizando herramientas como Recorded Future.

Estas estrategias no solo mitigan riesgos inmediatos, sino que fomentan una cultura de resiliencia cibernética, alineada con estándares como NIST Cybersecurity Framework.

Implicaciones Regulatorias, Éticas y Futuras Tendencias

Desde el punto de vista regulatorio, el uso de IA en phishing plantea desafíos para marcos como el EU AI Act, que clasifica aplicaciones de alto riesgo y exige transparencia en modelos generativos. En América Latina, regulaciones como la LGPD en Brasil y la LFPDPPP en México demandan reportes de incidentes que incluyan análisis de IA, promoviendo auditorías obligatorias en sectores críticos.

Éticamente, la proliferación de estas herramientas cuestiona la responsabilidad de proveedores de IA, como OpenAI, que implementan safeguards pero enfrentan jailbreaks (técnicas para eludir restricciones). Los beneficios de la IA en ciberseguridad, como detección predictiva mediante reinforcement learning, deben equilibrarse con riesgos de dual-use technology.

Mirando hacia el futuro, tendencias como la federated learning permitirán entrenar modelos defensivos sin compartir datos sensibles, mientras que quantum computing podría romper encriptaciones actuales, exacerbando phishing. Investigadores predicen un aumento del 50% en ataques IA-híbridos para 2025, urgiendo inversión en R&D para contramedidas.

En resumen, el empleo de IA en phishing transforma el paisaje de amenazas, demandando innovación continua en defensas técnicas y políticas. Profesionales deben priorizar la integración de estas tecnologías en protocolos de seguridad integral, asegurando la protección de activos digitales en un ecosistema cada vez más interconectado.

Para más información, visita la Fuente original.