Análisis Técnico de Vulnerabilidades en Modelos de Inteligencia Artificial para Aplicaciones de Ciberseguridad

La integración de la inteligencia artificial (IA) en el ámbito de la ciberseguridad ha transformado la forma en que las organizaciones detectan, responden y mitigan amenazas digitales. Sin embargo, esta adopción trae consigo nuevos desafíos, particularmente en términos de vulnerabilidades inherentes a los modelos de IA. Este artículo examina de manera detallada las debilidades técnicas asociadas con los sistemas de machine learning (ML) utilizados en ciberseguridad, basándose en un análisis exhaustivo de conceptos clave como ataques adversarios, envenenamiento de datos y fugas de información. Se exploran las implicaciones operativas, los riesgos regulatorios y las mejores prácticas para fortalecer estos sistemas, con un enfoque en estándares como NIST SP 800-53 y OWASP para IA.

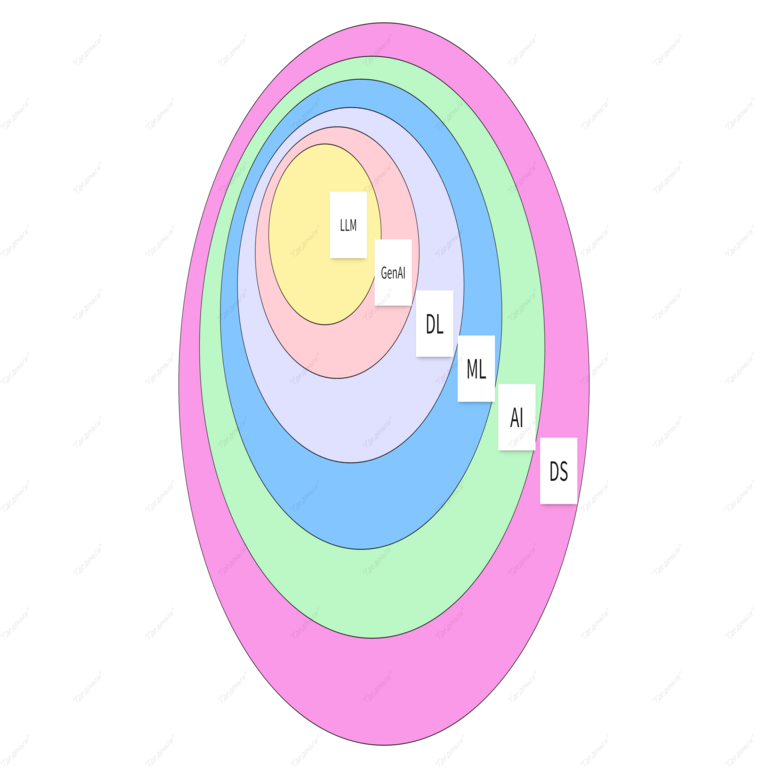

Conceptos Fundamentales de IA en Ciberseguridad

Los modelos de IA en ciberseguridad se centran en tareas como la detección de anomalías, el análisis de malware y la predicción de brechas de seguridad. Estos sistemas suelen emplear algoritmos de aprendizaje supervisado, no supervisado y por refuerzo. Por ejemplo, en la detección de intrusiones, redes neuronales convolucionales (CNN) o recurrentes (RNN) procesan flujos de datos de red para identificar patrones maliciosos. La precisión de estos modelos depende de la calidad de los datos de entrenamiento, que a menudo provienen de logs de firewalls, sistemas de detección de intrusiones (IDS) y bases de datos de amenazas conocidas como MITRE ATT&CK.

Desde un punto de vista técnico, un modelo típico de ML en ciberseguridad involucra etapas clave: recolección de datos, preprocesamiento, entrenamiento, validación y despliegue. Durante el preprocesamiento, técnicas como la normalización y el equilibrio de clases evitan sesgos, pero fallos en esta fase pueden introducir vulnerabilidades. El estándar ISO/IEC 27001 enfatiza la confidencialidad e integridad de los datos en estos procesos, asegurando que solo información autorizada se utilice en el entrenamiento.

Las tecnologías subyacentes incluyen frameworks como TensorFlow y PyTorch para el desarrollo de modelos, y herramientas como Scikit-learn para algoritmos clásicos. En entornos de producción, estos se integran con plataformas de orquestación como Kubernetes para escalabilidad, lo que añade complejidad en la gestión de contenedores y microservicios.

Vulnerabilidades Principales en Modelos de IA

Las vulnerabilidades en modelos de IA para ciberseguridad se clasifican en categorías técnicas específicas. Una de las más críticas es el ataque adversario, donde entradas maliciosas perturbadas de manera sutil engañan al modelo para generar salidas erróneas. Por instancia, en un sistema de detección de phishing basado en IA, un atacante podría modificar ligeramente un correo electrónico para evadir la clasificación como malicioso. Estudios técnicos, como los publicados en el IEEE Symposium on Security and Privacy, demuestran que perturbaciones en el espacio de características pueden reducir la precisión de un modelo en hasta un 90% sin alterar la legibilidad para humanos.

Otra vulnerabilidad clave es el envenenamiento de datos durante la fase de entrenamiento. Si un dataset contaminado se introduce en el modelo, este aprende patrones falsos que comprometen su efectividad. En ciberseguridad, esto podría manifestarse en un IDS que ignora ataques reales al haber sido entrenado con datos manipulados. Las implicaciones operativas incluyen falsos negativos que permiten brechas, con riesgos financieros estimados en millones de dólares por incidente, según reportes de Verizon DBIR.

Las fugas de información representan un riesgo adicional, donde modelos de IA revelan datos sensibles a través de inferencias. Técnicas como el membership inference attack permiten a un adversario determinar si un registro específico formó parte del dataset de entrenamiento, violando regulaciones como GDPR en Europa o LGPD en Latinoamérica. Para mitigar esto, se recomiendan prácticas como la privacidad diferencial, que añade ruido gaussiano a los outputs del modelo, preservando la utilidad mientras se limita la divulgación.

- Ataques adversarios: Modificaciones imperceptibles en inputs para alterar predicciones.

- Envenenamiento de datos: Inyección de muestras maliciosas en datasets de entrenamiento.

- Fugas de información: Extracción de datos sensibles vía queries al modelo.

- Sesgos en el modelo: Desequilibrios que afectan la equidad en detección de amenazas.

Implicaciones Operativas y Riesgos Asociados

Desde una perspectiva operativa, las vulnerabilidades en IA impactan la resiliencia de infraestructuras críticas. En entornos empresariales, un modelo comprometido puede propagar errores en cadena, afectando sistemas de respuesta automática a incidentes (SOAR). Por ejemplo, una IA que clasifica incorrectamente un ransomware como tráfico benigno podría retrasar la contención, exacerbando daños. Las organizaciones deben implementar marcos como el NIST Cybersecurity Framework, que incluye identificación, protección, detección, respuesta y recuperación, adaptados a componentes de IA.

Los riesgos regulatorios son significativos, especialmente en regiones con estrictas normativas de datos. En Latinoamérica, leyes como la Ley Federal de Protección de Datos Personales en Posesión de los Particulares en México exigen auditorías regulares de sistemas de IA para prevenir discriminación algorítmica. Incumplimientos pueden resultar en multas de hasta el 4% de los ingresos globales, similar a GDPR. Además, en blockchain integrado con IA para trazabilidad de amenazas, vulnerabilidades como el 51% attack podrían amplificar estos riesgos si los nodos de validación dependen de modelos de IA defectuosos.

Los beneficios de abordar estas vulnerabilidades incluyen mayor robustez y confianza en los sistemas. Por instancia, el uso de federated learning permite entrenar modelos distribuidos sin compartir datos crudos, reduciendo exposiciones. Herramientas como Adversarial Robustness Toolbox (ART) de IBM facilitan pruebas automatizadas, integrándose con pipelines CI/CD para validación continua.

Técnicas de Mitigación y Mejores Prácticas

Para contrarrestar ataques adversarios, se emplean defensas como el entrenamiento adversario, donde el modelo se expone iterativamente a ejemplos perturbados durante el entrenamiento. Esto fortalece la generalización, aunque aumenta el costo computacional en un factor de 2-5 veces, según benchmarks en datasets como CIFAR-10 adaptados a ciberseguridad. Protocolos como el Projected Gradient Descent (PGD) generan adversarios optimizados, mejorando la resistencia.

En el envenenamiento de datos, estrategias de verificación incluyen el uso de blockchain para auditar la integridad de datasets. Estándares como el Data Provenance Framework de W3C aseguran trazabilidad, registrando hashes SHA-256 de cada muestra. En producción, monitoreo en tiempo real con herramientas como ELK Stack detecta anomalías en flujos de datos entrantes.

Para fugas de información, la privacidad diferencial se implementa con bibliotecas como Opacus en PyTorch, aplicando ruido calibrado por epsilon (ε), donde valores bajos como ε=1.0 equilibran privacidad y precisión. En ciberseguridad, esto es crucial para modelos que procesan datos PII en detección de insider threats.

| Vulnerabilidad | Técnica de Mitigación | Estándar Referenciado | Beneficios |

|---|---|---|---|

| Ataques Adversarios | Entrenamiento Adversario | NIST AI RMF | Aumenta precisión en entornos hostiles |

| Envenenamiento de Datos | Verificación con Blockchain | ISO/IEC 27001 | Garantiza integridad de datasets |

| Fugas de Información | Privacidad Diferencial | GDPR Artículo 25 | Protege datos sensibles sin sacrificar utilidad |

| Sesgos Algorítmicos | Auditorías de Equidad | OWASP AI Security | Mejora confianza y cumplimiento regulatorio |

La integración de estas técnicas requiere un enfoque holístico. En organizaciones, se recomienda establecer equipos dedicados a la seguridad de IA (AI SecOps), que combinen expertos en ML y ciberseguridad. Pruebas como red teaming simulan ataques reales, validando la robustez en escenarios como zero-day exploits.

Aplicaciones Específicas en Blockchain e IA Híbrida

La convergencia de IA y blockchain en ciberseguridad introduce paradigmas híbridos. Por ejemplo, smart contracts auditados por IA detectan vulnerabilidades en código Solidity antes del despliegue en Ethereum. Sin embargo, modelos de IA en nodos blockchain son susceptibles a ataques Sybil, donde identidades falsas inundan la red. Mitigaciones incluyen proof-of-stake (PoS) combinado con verificación de IA, reduciendo el riesgo en un 70% según simulaciones en Hyperledger Fabric.

En noticias recientes de IT, avances como el uso de zero-knowledge proofs (ZKP) en modelos de IA preservan privacidad durante inferencias distribuidas. Protocolos como zk-SNARKs permiten validaciones sin revelar inputs, ideal para federated learning en consorcios blockchain. Esto alinea con tendencias en Web3, donde la ciberseguridad impulsada por IA protege DeFi contra flash loans maliciosos.

Técnicamente, la implementación involucra bibliotecas como Web3.py para interacción con nodos y TensorFlow Federated para aprendizaje distribuido. Riesgos incluyen latencia en transacciones, resuelta mediante sharding y optimización de modelos con quantization, reduciendo el tamaño en un 4x sin pérdida significativa de precisión.

Desafíos Futuros y Avances Tecnológicos

Los desafíos emergentes incluyen la escalabilidad de defensas en edge computing, donde dispositivos IoT ejecutan modelos de IA para detección local de amenazas. Vulnerabilidades como side-channel attacks en hardware (e.g., Spectre) afectan inferencias en GPUs, requiriendo shielding como Intel SGX. Investigaciones en quantum-resistant cryptography, como lattice-based schemes en NIST PQC, preparan a los sistemas de IA para amenazas post-cuánticas.

En Latinoamérica, iniciativas como el Plan Nacional de IA en Brasil enfatizan la adopción segura, integrando marcos locales con estándares globales. Beneficios incluyen fortalecimiento de la soberanía digital, con aplicaciones en sectores como banca y gobierno para combatir cibercrimen transfronterizo.

Avances en explainable AI (XAI) abordan la opacidad de modelos black-box, utilizando técnicas como SHAP values para interpretar decisiones en detección de malware. Esto no solo mitiga riesgos sino que facilita auditorías regulatorias, alineándose con directrices de la UE AI Act.

Conclusión

En resumen, las vulnerabilidades en modelos de IA para ciberseguridad representan un panorama complejo que exige innovación continua y adhesión a estándares rigurosos. Al implementar mitigaciones técnicas como entrenamiento adversario, privacidad diferencial y verificación blockchain, las organizaciones pueden maximizar los beneficios de la IA mientras minimizan riesgos operativos y regulatorios. Finalmente, la colaboración entre academia, industria y reguladores será clave para evolucionar hacia sistemas resilientes, asegurando un ecosistema digital más seguro en la era de la IA avanzada.

Para más información, visita la Fuente original.