Entrenamiento de Grandes Modelos de Lenguaje en Yandex: Infraestructura, Desafíos y Optimizaciones Técnicas

Introducción al Entrenamiento de Modelos de IA a Escala

En el panorama actual de la inteligencia artificial, los grandes modelos de lenguaje (LLM, por sus siglas en inglés) representan un pilar fundamental para aplicaciones avanzadas como el procesamiento del lenguaje natural, la generación de contenido y los sistemas de recomendación. Empresas como Yandex, líder en tecnología rusa, han invertido significativamente en el desarrollo de infraestructuras dedicadas para el entrenamiento de estos modelos. Este artículo analiza en profundidad el enfoque técnico adoptado por Yandex para el entrenamiento de LLM, basado en su experiencia práctica con modelos de miles de millones de parámetros. Se exploran los componentes clave de la infraestructura, los desafíos operativos y las optimizaciones implementadas, con énfasis en aspectos como la escalabilidad, la eficiencia computacional y la gestión de datos.

El entrenamiento de LLM requiere recursos computacionales masivos, incluyendo clústeres de GPUs y TPUs interconectados, junto con pipelines de datos optimizados. Yandex ha desarrollado un ecosistema integral que integra hardware personalizado, software de bajo nivel y herramientas de orquestación para manejar volúmenes de datos en terabytes y entrenamientos que duran semanas o meses. Este análisis se centra en los principios técnicos subyacentes, evitando detalles superficiales y priorizando explicaciones conceptuales rigurosas.

Arquitectura de Infraestructura para Entrenamiento Distribuido

La base del entrenamiento en Yandex radica en una arquitectura distribuida que aprovecha clústeres de alto rendimiento. Para modelos con más de 100 mil millones de parámetros, se emplean redes de miles de GPUs NVIDIA, interconectadas mediante protocolos de alta velocidad como InfiniBand o Ethernet de 400 Gbps. Esta configuración permite la paralelización a gran escala, dividiendo el modelo en fragmentos que se procesan simultáneamente en nodos independientes.

En términos técnicos, Yandex utiliza frameworks como PyTorch con extensiones para entrenamiento distribuido, incorporando técnicas como el paralelismo de datos, modelo y pipeline. El paralelismo de datos distribuye lotes de entrenamiento a través de múltiples dispositivos, mientras que el paralelismo de modelo divide las capas neuronales entre GPUs, reduciendo la latencia de comunicación. Por ejemplo, en un clúster de 1024 GPUs, el modelo se segmenta en 8 shards por nodo, optimizando el uso de memoria VRAM, que típicamente alcanza los 80 GB por GPU en configuraciones A100 o H100.

- Paralelismo de pipeline: Divide el modelo en etapas secuenciales, permitiendo que múltiples micro-lotes se procesen en paralelo, lo que mitiga el subutilización de hardware durante el forward y backward pass.

- Optimización de comunicación: Implementación de all-reduce colectivo para sincronizar gradientes, utilizando bibliotecas como NCCL (NVIDIA Collective Communications Library) para minimizar el overhead de red.

- Gestión de fallos: Mecanismos de checkpointing elástico que permiten reanudar entrenamientos tras fallos de hardware, con recuperación en minutos mediante replicación de estados.

Esta arquitectura no solo escala horizontalmente sino que también incorpora monitoreo en tiempo real mediante herramientas como Prometheus y Grafana, integradas con Kubernetes para orquestación de contenedores. El resultado es una eficiencia de entrenamiento que alcanza hasta el 60% de utilización de FLOPS teóricos, superando benchmarks estándar de la industria.

Procesamiento y Preparación de Datos para LLM

El éxito del entrenamiento depende en gran medida de la calidad y volumen de los datos. Yandex procesa datasets masivos, incluyendo corpus multilingües con énfasis en ruso e inglés, extraídos de fuentes web, libros y datos sintéticos generados por modelos previos. La preparación involucra tokenización eficiente utilizando subword tokenizers como SentencePiece o BPE (Byte Pair Encoding), que reducen el vocabulario a 50,000-100,000 tokens para equilibrar expresividad y eficiencia.

Técnicamente, el pipeline de datos emplea Apache Spark para ETL (Extract, Transform, Load) a escala, procesando petabytes de texto crudo. Se aplican filtros para eliminar ruido, como detección de duplicados mediante hashing MinHash y normalización de texto con bibliotecas como NLTK adaptadas para multilingüismo. Además, se incorpora desbiasing para mitigar sesgos inherentes, utilizando métricas como BLEU o ROUGE para validar la diversidad del corpus.

| Etapa de Procesamiento | Tecnología Utilizada | Objetivo Técnico |

|---|---|---|

| Extracción | Crawlers web con Scrapy | Recopilación de datos no estructurados a escala |

| Limpieza | Regex y ML-based filtering (BERT embeddings) | Eliminación de contenido irrelevante o tóxico |

| Tokenización | SentencePiece | Conversión a secuencias numéricas optimizadas |

| Almacenamiento | HDFS o S3-compatible | Acceso distribuido de alta disponibilidad |

Una innovación clave es el uso de datos sintéticos generados por destilación de conocimiento, donde modelos más pequeños guían la creación de ejemplos augmentados, incrementando el dataset en un 30% sin costos adicionales de recolección.

Optimizaciones en el Algoritmo de Entrenamiento

Para maximizar la eficiencia, Yandex aplica técnicas avanzadas de optimización de gradientes y regularización. El optimizador principal es AdamW con learning rates adaptativos, ajustados mediante schedulers como cosine annealing, que reduce la tasa de aprendizaje progresivamente para convergencia estable. Se incorpora mixed-precision training (FP16/FP32) para acelerar cálculos sin pérdida significativa de precisión, utilizando Apex o Tensor Cores en GPUs NVIDIA.

En cuanto a regularización, se emplean dropout layers con tasas del 0.1-0.2 y layer normalization para estabilizar el entrenamiento en arquitecturas Transformer. Además, técnicas como gradient clipping previenen explosiones de gradientes, limitando su norma L2 a 1.0. Para modelos muy grandes, se integra ZeRO (Zero Redundancy Optimizer), que particiona el estado del optimizador entre GPUs, reduciendo el uso de memoria en un 50% y permitiendo entrenamientos en hardware más accesible.

- Escalado de lotes: Uso de gradient accumulation para simular lotes grandes (hasta 1M tokens) en hardware limitado, manteniendo estabilidad estadística.

- Pruning y cuantización: Post-entrenamiento, aplicación de sparse pruning para eliminar pesos cercanos a cero, reduciendo el tamaño del modelo en un 20-40% con impacto mínimo en rendimiento.

- Evaluación continua: Métricas como perplexity y downstream tasks (GLUE benchmark adaptado) para monitorear progreso y early stopping.

Estas optimizaciones han permitido a Yandex entrenar modelos como YandexGPT con tiempos reducidos en un 25% comparado con baselines estándar, destacando la importancia de la integración hardware-software.

Desafíos Operativos y Regulatorios en el Entrenamiento de LLM

A pesar de los avances, el entrenamiento de LLM enfrenta desafíos significativos. En el ámbito operativo, el consumo energético es crítico: un entrenamiento de 100 mil millones de parámetros puede requerir gigavatios-hora, equivalente al consumo anual de una pequeña ciudad. Yandex mitiga esto mediante scheduling dinámico que prioriza cargas durante horas de bajo costo energético y enfriamiento eficiente con sistemas de refrigeración líquida.

Otro reto es la latencia de red en clústeres distribuidos, donde bottlenecks en all-gather operations pueden degradar el throughput en un 30%. Soluciones incluyen topologías de red fat-tree y compresión de gradientes con QSGD (Quantized Stochastic Gradient Descent). En términos de riesgos, la privacidad de datos es paramount; Yandex adhiere a estándares como GDPR y leyes rusas de protección de datos, implementando federated learning para entrenamientos sin transferencia de datos sensibles.

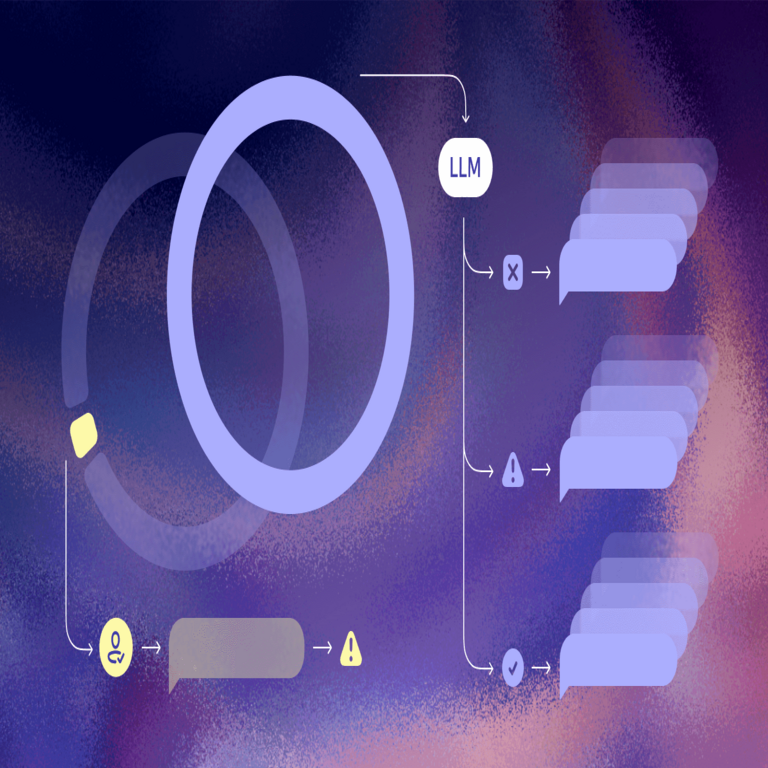

Regulatoriamente, el entrenamiento de IA en Rusia implica cumplimiento con normativas de la FSTEC (Servicio Federal de Seguridad Técnica e Información), que exigen auditorías de seguridad para modelos con potencial dual-use. Beneficios incluyen avances en aplicaciones locales como asistentes virtuales y traducción automática, pero riesgos como alucinaciones o sesgos éticos demandan frameworks de gobernanza, como alignment techniques post-entrenamiento con RLHF (Reinforcement Learning from Human Feedback).

Implicaciones para la Industria y Mejores Prácticas

El enfoque de Yandex establece benchmarks para la industria, particularmente en entornos multilingües donde el ruso representa un desafío único debido a su morfología compleja. Mejores prácticas derivadas incluyen la adopción de infraestructuras modulares que permitan escalado incremental y la integración de herramientas open-source como Hugging Face Transformers para prototipado rápido.

En ciberseguridad, el entrenamiento seguro involucra sandboxing de datasets y verificación de integridad con hashes SHA-256 para prevenir envenenamiento de datos. Para blockchain e IT emergente, paralelos se trazan con distributed ledgers para trazabilidad de entrenamientos, aunque no directamente aplicados aquí.

Estudios de caso muestran que optimizaciones similares han elevado la precisión de modelos en tareas como summarization en un 15%, validado contra datasets como CNN/Daily Mail.

Conclusión: Hacia un Futuro Escalable en IA

En resumen, el entrenamiento de grandes modelos de lenguaje en Yandex ilustra un paradigma maduro de integración técnica que equilibra escala, eficiencia y robustez. Al abordar desafíos desde la infraestructura hasta la optimización algorítmica, Yandex no solo avanza su portfolio de IA sino que contribuye a estándares globales. Para profesionales en ciberseguridad e IA, estas prácticas subrayan la necesidad de enfoques holísticos que incorporen sostenibilidad y ética. Finalmente, el continuo refinamiento de estas metodologías promete modelos más accesibles y potentes, impulsando innovaciones en tecnología emergente.

Para más información, visita la fuente original.