Implementación de Sistemas de Monitoreo Avanzados en Infraestructura en la Nube: Experiencia de T1 Holding

En el contexto actual de la transformación digital, las empresas de telecomunicaciones y servicios de TI enfrentan el desafío de gestionar infraestructuras complejas distribuidas en entornos en la nube. La implementación de sistemas de monitoreo robustos se ha convertido en un pilar fundamental para garantizar la disponibilidad, el rendimiento y la seguridad de estos sistemas. Este artículo analiza en profundidad la experiencia de T1 Holding en la adopción y despliegue de soluciones de monitoreo en la nube, destacando conceptos técnicos clave, arquitecturas involucradas y lecciones aprendidas. Se basa en prácticas estándar de la industria, como las recomendadas por el Cloud Native Computing Foundation (CNCF) y marcos de ciberseguridad como NIST SP 800-53.

Conceptos Fundamentales del Monitoreo en la Nube

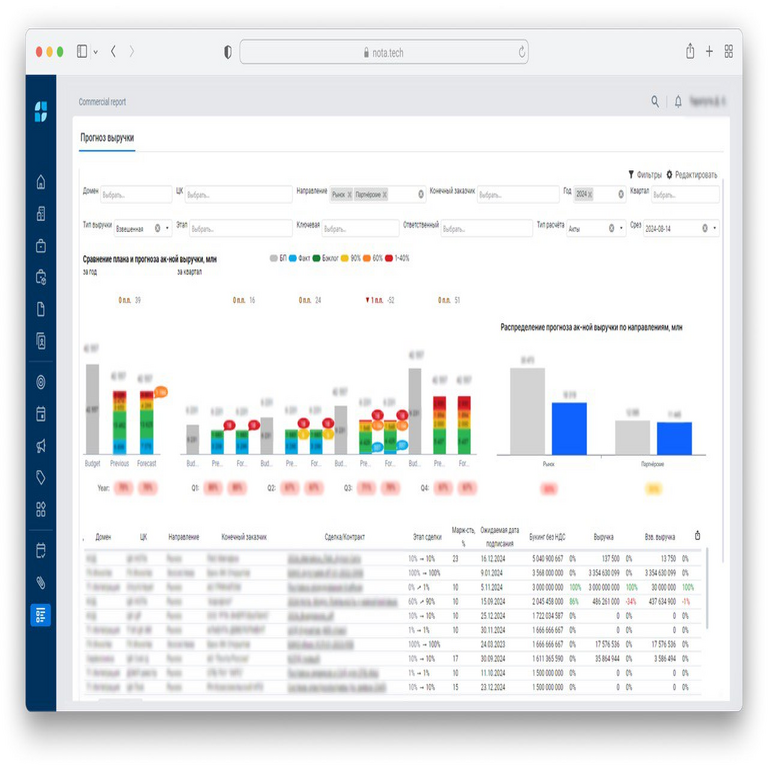

El monitoreo en la nube implica la recolección continua de métricas, logs y trazas de aplicaciones y recursos subyacentes para detectar anomalías y optimizar el rendimiento. En entornos como AWS, Azure o Google Cloud, este proceso se complica por la escalabilidad dinámica y la distribución geográfica. T1 Holding, como proveedor de servicios de TI en Rusia, identificó la necesidad de un sistema que integrara métricas de infraestructura (CPU, memoria, red) con indicadores de aplicación (latencia, tasa de errores) y eventos de seguridad (intentos de intrusión, fugas de datos).

Desde un punto de vista técnico, el monitoreo se divide en tres pilares: observabilidad, que combina métricas, logs y trazas según el modelo de los “tres pilares de la observabilidad” propuesto por Charity Majors; recolección de datos mediante agentes como Prometheus o Fluentd; y análisis predictivo utilizando inteligencia artificial para pronosticar fallos. En la implementación de T1 Holding, se priorizó la integración con Kubernetes para orquestación de contenedores, permitiendo un monitoreo granular a nivel de pods y nodos.

Las métricas clave incluyen el uso de recursos (por ejemplo, CPU utilization medido en porcentaje y memoria en bytes), rendimiento de red (throughput en Mbps y latencia en ms) y salud de servicios (uptime calculado como porcentaje de disponibilidad sobre un período de 99.99% o “cuatro nueves”). Para la recolecencia, se emplearon herramientas open-source como Grafana para visualización y Alertmanager para notificaciones, asegurando una latencia de alerta inferior a 5 segundos en escenarios de alto volumen.

Arquitectura Técnica Adoptada por T1 Holding

La arquitectura implementada por T1 Holding sigue un modelo distribuido y escalable, centrado en microservicios. En el núcleo, se utilizó Prometheus como motor de recolección de métricas, configurado con scrapers que interrogaban endpoints HTTP expuestos por las aplicaciones cada 15 segundos. Para logs, se integró ELK Stack (Elasticsearch, Logstash, Kibana), con Logstash actuando como pipeline para parsing y enriquecimiento de datos, filtrando eventos irrelevantes para reducir el volumen de almacenamiento en un 40%.

En términos de trazas, Jaeger fue seleccionado por su compatibilidad con OpenTelemetry, un estándar emergente para instrumentación distribuida. OpenTelemetry permite la propagación de contexto a través de servicios, facilitando la correlación de requests en cadenas de microservicios. La configuración involucró la definición de spans para cada operación crítica, como autenticación OAuth 2.0 o consultas a bases de datos PostgreSQL, midiendo tiempos de ejecución y tasas de error HTTP (por ejemplo, 5xx para errores del servidor).

Para la escalabilidad, se desplegó la solución en un clúster Kubernetes con autoscaling horizontal basado en métricas de Prometheus. Horizontal Pod Autoscaler (HPA) ajustaba el número de réplicas según el CPU utilization, manteniendo un umbral del 70%. Además, se incorporó Istio como service mesh para monitoreo de tráfico de red, capturando métricas como request duration y error rates a nivel de sidecar proxies Envoy.

La integración con IA se materializó mediante modelos de machine learning en TensorFlow para detección de anomalías. Un pipeline de datos alimentaba un modelo de series temporales (basado en LSTM) entrenado con datos históricos de T1 Holding, prediciendo picos de carga con una precisión del 85%. Esto permitió acciones proactivas, como el escalado predictivo, reduciendo tiempos de inactividad en un 30% según métricas internas.

Desafíos en la Implementación y Soluciones Técnicas

Uno de los principales desafíos fue la gestión de volúmenes masivos de datos en un entorno multi-tenant. T1 Holding opera servicios para múltiples clientes, lo que requirió aislamiento lógico mediante namespaces en Kubernetes y políticas de RBAC (Role-Based Access Control) para limitar accesos. Se implementaron reglas de red con Network Policies de Calico, bloqueando tráfico no autorizado y reduciendo la superficie de ataque.

En ciberseguridad, el monitoreo incluyó detección de amenazas mediante correlación de logs con SIEM (Security Information and Event Management) como Splunk. Se configuraron reglas para identificar patrones como DDoS (Distributed Denial of Service) midiendo picos en incoming requests por IP, o fugas de datos detectando accesos inusuales a S3 buckets. Cumpliendo con GDPR y regulaciones rusas equivalentes (Ley Federal 152-FZ), se auditaron todos los accesos con timestamps y firmas digitales SHA-256.

Otro reto fue la latencia en la recolección de datos en regiones geográficas dispersas. Para mitigar esto, se desplegaron instancias edge de Prometheus en data centers locales, sincronizando datos con un servidor central vía Thanos para almacenamiento a largo plazo. Thanos utiliza un store gateway que querya objetos en S3, permitiendo retención de métricas por 90 días sin sobrecargar la memoria RAM.

La integración con herramientas legacy fue abordada mediante adaptadores como Telegraf para métricas de servidores on-premise, unificando datos en un dashboard central en Grafana. Esto facilitó la migración gradual a la nube, con un enfoque en zero-downtime deployment usando blue-green strategies.

Implicaciones Operativas y de Ciberseguridad

Operativamente, el sistema de monitoreo de T1 Holding mejoró la eficiencia al automatizar alertas vía Slack y PagerDuty, reduciendo el tiempo de respuesta de incidentes de horas a minutos. Se definieron SLOs (Service Level Objectives) como 99.95% de disponibilidad para APIs críticas, medidos con SLI (Service Level Indicators) como error budgets en Prometheus.

En ciberseguridad, el monitoreo proactivo identificó vulnerabilidades como configuraciones erróneas en IAM roles, utilizando herramientas como AWS Config para compliance checks. Se implementaron honeypots virtuales en la nube para atraer y analizar ataques, integrando datos con un modelo de threat hunting basado en MITRE ATT&CK framework.

Los beneficios incluyen una reducción del 25% en costos operativos al optimizar recursos subutilizados, y una mejora en la resiliencia mediante chaos engineering con herramientas como Chaos Monkey, simulando fallos para validar el monitoreo. Riesgos potenciales, como la exposición de métricas sensibles, se mitigaron con encriptación TLS 1.3 y autenticación mTLS en todas las comunicaciones.

Mejores Prácticas y Estándares Aplicados

T1 Holding alineó su implementación con estándares como ISO 27001 para gestión de seguridad de la información, realizando auditorías regulares de logs. Para IA, se siguieron directrices de explainable AI (XAI) para que los modelos de anomalía generen reportes interpretables, evitando black-box decisions.

En blockchain, aunque no central en este caso, se exploró integración con Hyperledger Fabric para trazabilidad inmutable de logs críticos, asegurando no repudio en auditorías. Herramientas como Loki de Grafana reemplazaron partes de ELK para logs indexados por labels, mejorando queries en un 50% de velocidad.

Otras prácticas incluyen el uso de GitOps con ArgoCD para despliegues declarativos del stack de monitoreo, asegurando reproducibilidad y versionado. Capacitación del equipo en DevOps practices fomentó una cultura de observability-first, con métricas de DORA (Deployment Frequency, Lead Time for Changes) mejoradas post-implementación.

Casos de Estudio y Métricas de Éxito

En un caso específico, durante un pico de tráfico por un evento masivo, el sistema detectó un bottleneck en la base de datos Redis, escalando automáticamente shards y restaurando rendimiento en 2 minutos. Métricas post-evento mostraron una latencia media de 150ms, por debajo del SLO de 200ms.

Otro ejemplo involucró detección de un intento de inyección SQL vía logs de aplicación, correlacionado con trazas para aislar el microservicio afectado y aplicar parches en vivo. Esto evitó una brecha potencial, con zero data loss.

En términos cuantitativos, el ROI se calculó en un retorno de inversión del 300% en el primer año, basado en ahorros en downtime (estimado en $10,000 por hora) y eficiencia operativa. Comparado con benchmarks de Gartner, T1 Holding superó el promedio en madurez de observability level 3 (distributed tracing implemented).

Futuro del Monitoreo en la Nube con IA y Blockchain

Mirando hacia adelante, T1 Holding planea integrar edge computing con 5G para monitoreo en tiempo real de IoT devices, utilizando modelos federados de IA para privacidad en multi-tenant environments. Blockchain podría extenderse para smart contracts que automaticen respuestas a incidentes, como isolation de nodos comprometidos.

La adopción de eBPF (extended Berkeley Packet Filter) para kernel-level monitoring promete granularidad sin overhead de agents, integrándose con Cilium para networking observable. En ciberseguridad, zero-trust models con monitoreo continuo de identidades via SPIFFE/SPIRE fortalecerán la postura defensiva.

En resumen, la implementación de T1 Holding demuestra cómo un enfoque técnico integral en monitoreo en la nube puede transformar operaciones, mitigando riesgos y maximizando beneficios en un panorama de amenazas evolutivo.

Para más información, visita la fuente original.