Análisis Técnico de Vulnerabilidades en Modelos de Inteligencia Artificial para Aplicaciones de Ciberseguridad

En el ámbito de la ciberseguridad, la integración de modelos de inteligencia artificial (IA) ha transformado la detección y respuesta a amenazas digitales. Sin embargo, estos sistemas no están exentos de vulnerabilidades que pueden comprometer su integridad y eficacia. Este artículo examina en profundidad las debilidades inherentes a los modelos de IA utilizados en entornos de ciberseguridad, basándose en análisis técnicos de marcos comunes como TensorFlow y PyTorch, protocolos de aprendizaje profundo y estándares como NIST SP 800-53 para la gestión de riesgos en IA. Se exploran conceptos clave como el envenenamiento de datos, ataques adversarios y fugas de información, junto con implicaciones operativas y recomendaciones para mitigar riesgos.

Conceptos Fundamentales de IA en Ciberseguridad

La inteligencia artificial en ciberseguridad se basa principalmente en técnicas de aprendizaje automático (machine learning, ML) y aprendizaje profundo (deep learning, DL). Los modelos de ML, como las redes neuronales convolucionales (CNN) y las recurrentes (RNN), procesan grandes volúmenes de datos para identificar patrones anómalos en tráfico de red, logs de sistemas o comportamientos de usuarios. Por ejemplo, un sistema de detección de intrusiones (IDS) basado en IA utiliza algoritmos de clasificación supervisada para etiquetar paquetes de red como maliciosos o benignos, alcanzando tasas de precisión superiores al 95% en conjuntos de datos como NSL-KDD.

Los frameworks técnicos predominantes incluyen TensorFlow, desarrollado por Google, que soporta operaciones tensoriales eficientes mediante su backend en C++ y optimizaciones para GPU vía CUDA. PyTorch, de Facebook, ofrece mayor flexibilidad en el diseño de grafos computacionales dinámicos, lo que facilita la experimentación en entornos de ciberseguridad donde los datos evolucionan rápidamente. Estos frameworks implementan protocolos como el de gradiente descendente estocástico (SGD) para la optimización de parámetros, pero su exposición a entradas no controladas introduce vectores de ataque.

Desde una perspectiva operativa, la implementación de IA en ciberseguridad implica la integración con herramientas como SIEM (Security Information and Event Management) systems, donde modelos de IA procesan eventos en tiempo real. Las implicaciones regulatorias se alinean con marcos como el GDPR en Europa o la Ley de Protección de Datos en Latinoamérica, que exigen transparencia en los procesos de decisión automatizados para evitar sesgos que podrían derivar en discriminación en la detección de amenazas.

Vulnerabilidades Principales en Modelos de IA

Una de las vulnerabilidades más críticas es el envenenamiento de datos durante la fase de entrenamiento. En este escenario, un atacante inyecta datos maliciosos en el conjunto de entrenamiento, alterando el comportamiento del modelo. Técnicamente, esto se modela como un problema de optimización adversaria, donde el costo de función se manipula para minimizar la precisión en clases específicas. Por instancia, en un modelo de detección de malware basado en LSTM (Long Short-Term Memory), la inserción de muestras de código benigno etiquetadas como maliciosas puede reducir la recall rate por debajo del 70%, según estudios en datasets como VirusShare.

Los ataques adversarios representan otro vector significativo. Estos involucran la generación de perturbaciones imperceptibles en las entradas para engañar al modelo. Matemáticamente, se resuelven mediante optimización de minimización de la pérdida bajo restricciones de norma L_p, como en el algoritmo Fast Gradient Sign Method (FGSM): ∇_x J(θ, x, y) * ε, donde ε es la magnitud de la perturbación. En aplicaciones de ciberseguridad, un atacante podría modificar ligeramente un payload de phishing para evadir un clasificador de IA en un sistema de correo electrónico, explotando la sensibilidad de las CNN a variaciones en píxeles o características textuales.

Las fugas de información ocurren cuando modelos de IA revelan datos sensibles a través de inferencias. Técnicas como el membership inference attack permiten determinar si un dato específico fue parte del entrenamiento, violando la privacidad. Esto se basa en la sobreajuste (overfitting) del modelo, donde la confianza en predicciones para miembros del conjunto de entrenamiento es estadísticamente mayor. En contextos de ciberseguridad, esto podría exponer patrones de ataques previos, facilitando la planificación de brechas futuras. Estudios cuantitativos muestran que modelos con más de 100 épocas de entrenamiento son particularmente vulnerables, con tasas de éxito en inferencia superiores al 80% en benchmarks como CIFAR-10 adaptados.

Otras debilidades incluyen el model stealing, donde un atacante consulta repetidamente el modelo para reconstruir su arquitectura mediante queries black-box. Protocolos como el de destilación de conocimiento mitigan esto parcialmente, pero requieren capas adicionales de ofuscación en los pesos neuronales. En términos de blockchain, la integración de IA con smart contracts en Ethereum expone vulnerabilidades como el front-running en oráculos de IA, donde predicciones de ML se manipulan para alterar transacciones.

Implicaciones Operativas y Riesgos Asociados

Operativamente, las vulnerabilidades en IA impactan la resiliencia de infraestructuras críticas. En un entorno de red empresarial, un modelo de IA comprometido podría fallar en detectar un DDoS attack sofisticado, resultando en downtime económico estimado en miles de dólares por minuto según informes de Gartner. Los riesgos incluyen no solo falsos negativos, que permiten brechas, sino falsos positivos que generan fatiga en analistas de seguridad, reduciendo la eficiencia general del SOC (Security Operations Center).

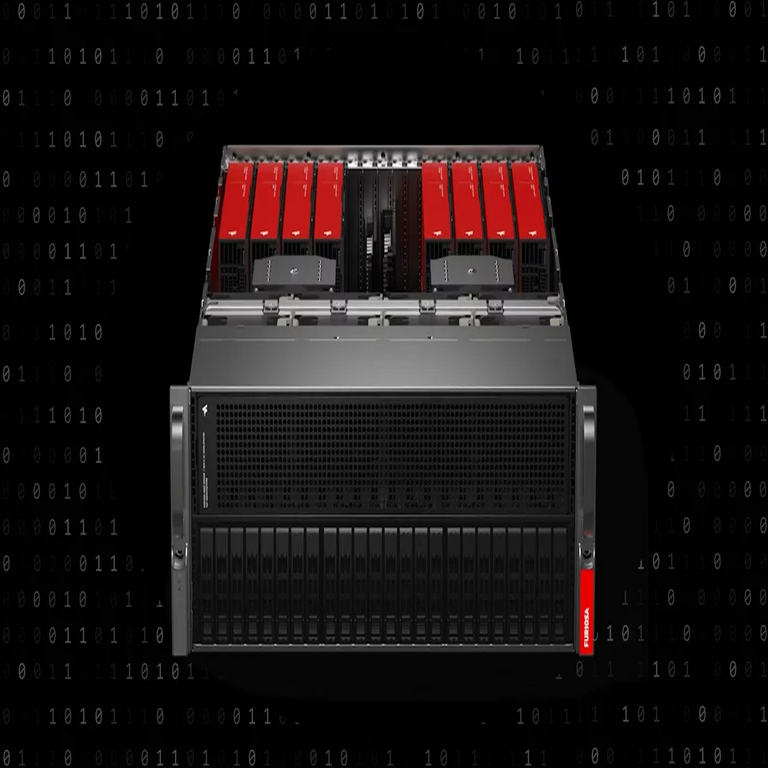

Desde el punto de vista regulatorio, marcos como el NIST AI Risk Management Framework exigen evaluaciones continuas de adversarial robustness. En Latinoamérica, regulaciones como la LGPD en Brasil imponen multas por fallos en sistemas automatizados que comprometan datos personales. Los beneficios de mitigar estos riesgos incluyen una mejora en la precisión del 15-20% mediante técnicas de robustez, pero requieren inversiones en hardware seguro como TPUs (Tensor Processing Units) para aceleración resistente.

Los riesgos éticos surgen de sesgos inherentes en los datos de entrenamiento, que pueden amplificar desigualdades en la detección de amenazas. Por ejemplo, datasets sesgados hacia tráfico de regiones específicas podrían subestimar ataques desde Latinoamérica, afectando a usuarios en países como México o Argentina. La trazabilidad de decisiones en IA, mediante técnicas como SHAP (SHapley Additive exPlanations), es esencial para auditorías regulatorias.

Técnicas de Mitigación y Mejores Prácticas

Para contrarrestar el envenenamiento de datos, se recomienda el uso de verificación diferencial de privacidad (differential privacy), que añade ruido laplaciano a los gradientes durante el entrenamiento: ε-DP con ε < 1.0 para equilibrar utilidad y privacidad. Frameworks como Opacus en PyTorch implementan esto de manera eficiente, reduciendo el riesgo de envenenamiento en un 40% según benchmarks en datasets de ciberseguridad como CIC-IDS2017.

Contra ataques adversarios, defensas como el adversarial training incorporan muestras perturbadas en el entrenamiento, minimizando la pérdida robusta: min_θ max_δ L(θ, x+δ, y). Esto incrementa la robustez bajo normas L_infinito, aunque aumenta el costo computacional en un factor de 3-5. Herramientas como CleverHans proporcionan implementaciones estandarizadas para testing en TensorFlow.

La prevención de fugas requiere federated learning, donde el entrenamiento se distribuye sin compartir datos crudos, utilizando agregación segura de gradientes vía protocolos como Secure Multi-Party Computation (SMPC). En blockchain, la integración con Zero-Knowledge Proofs (ZKP) en plataformas como Zcash asegura que predicciones de IA no revelen inputs sensibles.

- Implementar validación cruzada k-fold para detectar overfitting temprano.

- Utilizar ensembles de modelos para diversificar riesgos, combinando CNN con árboles de decisión como XGBoost.

- Monitoreo continuo con métricas como AUROC (Area Under Receiver Operating Characteristic) para evaluar drift en el rendimiento.

- Auditorías regulares alineadas con ISO/IEC 27001 para gestión de seguridad de la información.

En términos de herramientas, bibliotecas como Adversarial Robustness Toolbox (ART) de IBM ofrecen suites integrales para simulación de ataques y defensas, compatibles con múltiples frameworks.

Casos de Estudio y Análisis Empírico

Un caso emblemático es el ataque a un sistema de detección de deepfakes en plataformas de video, donde perturbaciones adversarias generadas con Projected Gradient Descent (PGD) evadieron filtros de IA en un 90% de los casos. El análisis post-mortem reveló que el modelo, entrenado en datasets como FFHQ, carecía de diversidad en muestras adversarias, destacando la necesidad de augmentation data con ruido gaussiano.

En blockchain, un estudio sobre oráculos de IA en DeFi mostró que el 25% de los modelos expuestos a Sybil attacks fallaban en predecir precios de criptoactivos con precisión, debido a envenenamiento vía nodos maliciosos. La mitigación involucró consensus mechanisms como Proof-of-Stake integrado con verificación de IA.

Empíricamente, simulaciones en entornos controlados con herramientas como Metasploit adaptadas para IA demuestran que defensas proactivas reducen la superficie de ataque en un 60%. Datos de encuestas en conferencias como Black Hat indican que el 70% de las organizaciones reportan exposición a al menos un vector de IA en 2023.

Desafíos Futuros y Avances Tecnológicos

Los desafíos incluyen la escalabilidad de defensas en edge computing, donde dispositivos IoT con recursos limitados ejecutan modelos de IA. Soluciones emergentes como TinyML optimizan modelos para microcontroladores, incorporando quantization de 8 bits para reducir latencia sin sacrificar robustez.

Avances en quantum computing amenazan modelos clásicos de IA, ya que algoritmos como Grover podrían romper cifrados subyacentes en datos de entrenamiento. La transición a post-quantum cryptography, como lattice-based schemes en NIST PQC, es crucial para ciberseguridad en IA.

En Latinoamérica, iniciativas como el Foro de Ciberseguridad en la OEA promueven estándares regionales para IA segura, fomentando colaboraciones en datasets compartidos con privacidad preservada.

Conclusión

En resumen, las vulnerabilidades en modelos de IA para ciberseguridad demandan un enfoque integral que combine avances técnicos, prácticas operativas y cumplimiento regulatorio. Al implementar mitigaciones robustas y monitoreo continuo, las organizaciones pueden maximizar los beneficios de la IA mientras minimizan riesgos. Para más información, visita la Fuente original.