Análisis de la Seguridad en Sistemas de Inteligencia Artificial

Introducción

En el contexto actual, donde la inteligencia artificial (IA) se integra cada vez más en diversas aplicaciones y servicios, la seguridad de estos sistemas se convierte en un aspecto crítico. Las vulnerabilidades en los algoritmos de IA pueden tener repercusiones significativas, desde la exposición a ataques cibernéticos hasta la manipulación de datos sensibles. Este artículo aborda los riesgos asociados a la seguridad en sistemas de IA y propone estrategias para mitigarlos.

Vulnerabilidades Comunes en Sistemas de IA

Las vulnerabilidades en sistemas de inteligencia artificial pueden clasificarse en varias categorías:

- Manipulación de Datos: Los ataques que modifican los datos utilizados para entrenar modelos de IA pueden afectar su rendimiento y exactitud.

- Modelos Adversarios: Se trata de técnicas que buscan engañar a los modelos al introducir ejemplos diseñados específicamente para provocar errores.

- Ataques por Inyección: Estos ataques consisten en insertar datos maliciosos con el fin de comprometer el funcionamiento del sistema.

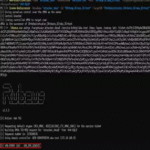

CVE Relacionados con Vulnerabilidades en IA

La comunidad de ciberseguridad ha identificado múltiples CVEs (Common Vulnerabilities and Exposures) que afectan a herramientas y bibliotecas utilizadas en inteligencia artificial. Algunos ejemplos incluyen:

- CVE-2025-29966: Esta vulnerabilidad permite a un atacante ejecutar código arbitrario mediante una inyección SQL dentro del proceso de entrenamiento del modelo.

Estrategias para Mitigar Riesgos

A continuación, se presentan algunas estrategias recomendadas para mejorar la seguridad en sistemas basados en inteligencia artificial:

- Auditoría Regular: Realizar auditorías periódicas para identificar vulnerabilidades y evaluar la efectividad de las medidas implementadas.

- Cifrado de Datos: Implementar cifrado tanto en reposo como durante la transmisión para proteger información sensible utilizada por modelos de IA.

- Técnicas de Aprendizaje Federado: Utilizar enfoques que permitan entrenar modelos sin necesidad de centralizar datos sensibles, reduciendo así el riesgo asociado al manejo directo de información crítica.

Implicaciones Regulatorias

A medida que los sistemas basados en inteligencia artificial continúan evolucionando, también lo hacen las normativas y regulaciones relacionadas con su uso. Es crucial que las organizaciones se mantengan informadas sobre las regulaciones vigentes que afectan la implementación y operación segura de estos sistemas. El cumplimiento normativo no solo ayuda a evitar sanciones legales sino que también refuerza la confianza del usuario final.

Conclusión

A medida que aumenta el uso e integración de sistemas basados en inteligencia artificial, es imperativo priorizar su seguridad. Las organizaciones deben adoptar un enfoque proactivo hacia la identificación y mitigación de riesgos, implementando prácticas sólidas que aseguren tanto los datos como el funcionamiento adecuado del sistema. Para más información visita la Fuente original.