Desafíos en la Detección de Imágenes Generadas por IA: Un Análisis del Test de Microsoft

Introducción

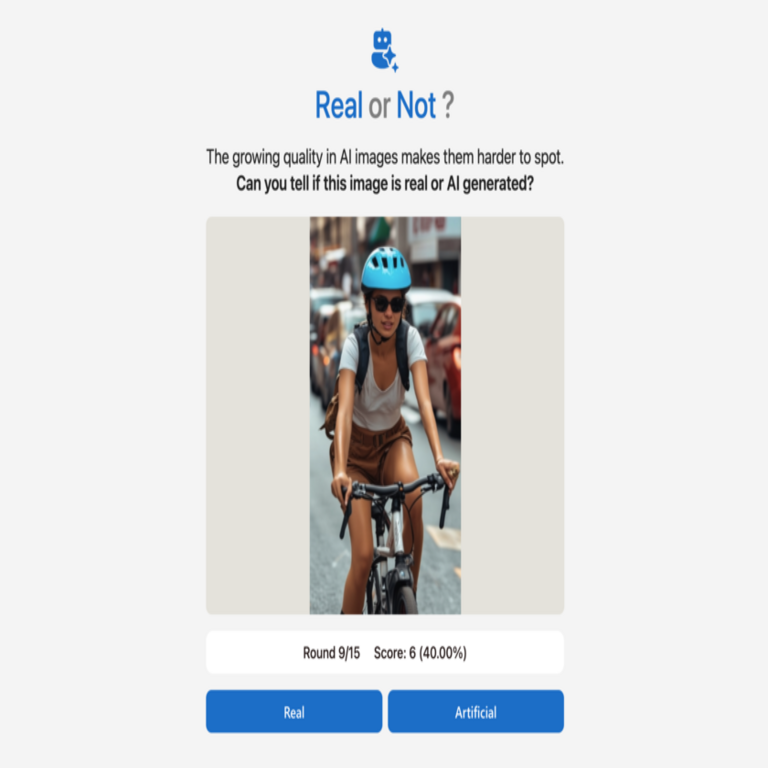

La creciente capacidad de la inteligencia artificial (IA) para generar imágenes realistas ha planteado importantes desafíos en la identificación y autenticidad de los contenidos digitales. Microsoft ha desarrollado un test ingenioso que desafía a los usuarios a distinguir entre imágenes generadas por IA y fotografías reales. Este artículo examina las implicaciones técnicas y operativas de este fenómeno, así como su relevancia en el campo de la ciberseguridad y la verificación de contenidos.

El Test de Microsoft

El test consiste en presentar a los participantes una serie de imágenes, donde deben identificar cuáles son generadas por inteligencia artificial. Los resultados han sido sorprendentes: una gran mayoría de los usuarios falla en esta tarea, lo que evidencia el alto nivel de sofisticación alcanzado por las herramientas generativas actuales.

Tecnologías Detrás del Test

Las tecnologías utilizadas para generar estas imágenes se basan principalmente en modelos avanzados de aprendizaje profundo, como Generative Adversarial Networks (GANs). Estos modelos utilizan un enfoque dual: uno genera imágenes mientras que el otro evalúa su realismo. A medida que estos modelos se entrenan, mejoran su capacidad para crear imágenes indistinguibles de las reales.

- Generative Adversarial Networks (GANs): Un marco fundamental en la generación de contenido visual mediante IA.

- TensorFlow: Una biblioteca popular utilizada para implementar modelos de aprendizaje profundo.

- PyTorch: Otra biblioteca ampliamente utilizada que permite realizar investigaciones en IA con facilidad.

Implicaciones Operativas y Regulatorias

La capacidad para generar imágenes hiperrealistas plantea serios riesgos desde el punto de vista operativo y regulatorio. En el ámbito empresarial, esto puede afectar la confianza del consumidor si no se pueden verificar fuentes auténticas. Además, hay cuestiones éticas sobre el uso indebido de estas tecnologías, como la creación de noticias falsas o contenido engañoso.

A nivel regulatorio, es esencial establecer directrices claras sobre la autenticidad del contenido digital generado por IA. Esto incluye:

- Desarrollo e implementación de estándares para la identificación y etiquetado de contenido generado por IA.

- Creciente necesidad de herramientas automatizadas que ayuden a verificar la autenticidad del contenido visual.

- Colaboración entre gobiernos y empresas tecnológicas para abordar estos desafíos éticos y legales.

Ciberseguridad y Verificación Digital

La ciberseguridad juega un papel crucial en este contexto. La dificultad para distinguir entre imágenes reales e imagenes generadas puede ser explotada en campañas desinformativas o ataques dirigidos. Herramientas avanzadas son necesarias no solo para crear contenido sino también para autenticarlo mediante técnicas como:

- Análisis forense digital: Evaluación detallada metadatos e integridad del archivo visual.

- Sistemas basados en blockchain: Registro inmutable que permite validar la procedencia del contenido digital.

- Sistemas automatizados que utilizan aprendizaje automático para detectar patrones anómalos en las imágenes.

Conclusión

A medida que avanzamos hacia un futuro donde las herramientas generativas sean cada vez más accesibles, es crucial desarrollar estrategias robustas tanto desde el punto técnico como regulatorio. La capacidad ficticia creada por las IA representa un reto significativo no solo hacia nuestra comprensión del arte digital sino también hacia nuestra percepción colectiva sobre la veracidad del contenido online. Para más información visita la Fuente original.