Nuevo vector de ataque en la cadena de suministro: Rules File Backdoor compromete editores de código con IA

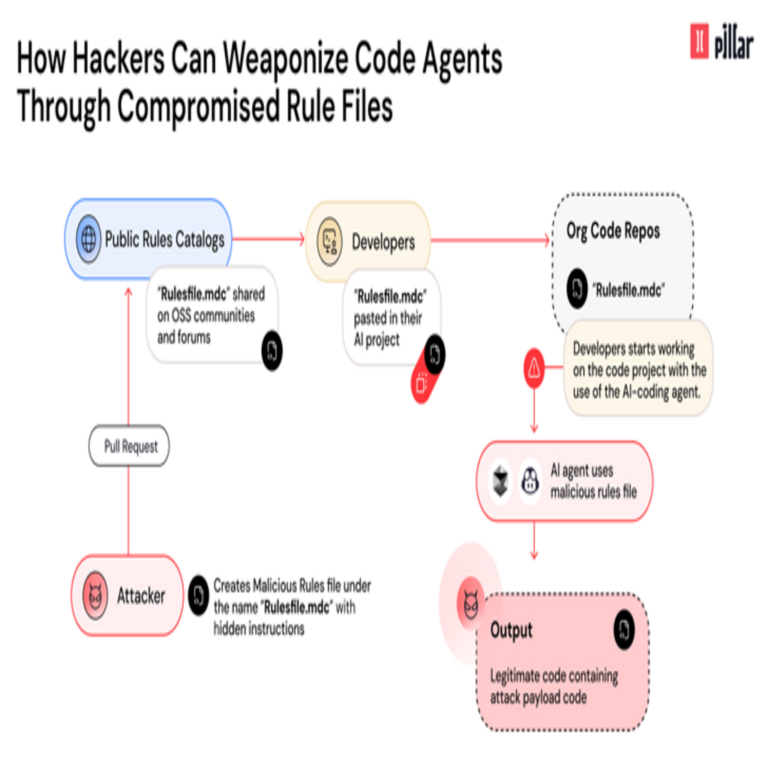

Investigadores en ciberseguridad han revelado un nuevo vector de ataque en la cadena de suministro, denominado Rules File Backdoor, que afecta a editores de código impulsados por inteligencia artificial (IA), como GitHub Copilot y Cursor. Este método permite a los atacantes inyectar código malicioso en proyectos de desarrollo de software de manera silenciosa, comprometiendo la integridad del código generado automáticamente.

¿Cómo funciona el ataque Rules File Backdoor?

El ataque aprovecha las funcionalidades de los editores de código basados en IA, que utilizan archivos de configuración o reglas (conocidos como “rules files”) para personalizar su comportamiento. Los atacantes manipulan estos archivos para introducir instrucciones ocultas que alteran el código generado por la IA. Aunque el código parece legítimo, contiene instrucciones maliciosas que pueden ejecutarse en tiempo de compilación o ejecución.

Por ejemplo, un archivo de reglas modificado podría hacer que la IA genere código que:

- Incluya vulnerabilidades conocidas, como inyecciones SQL o desbordamientos de búfer.

- Incorpore puertas traseras (backdoors) que permitan el acceso no autorizado a sistemas.

- Realice acciones maliciosas, como exfiltrar datos sensibles o instalar malware.

Implicaciones técnicas y riesgos

Este tipo de ataque representa una amenaza significativa para la seguridad del desarrollo de software, ya que:

- Los desarrolladores confían en herramientas como GitHub Copilot para acelerar la creación de código, pero no siempre revisan minuciosamente el código generado.

- La naturaleza automatizada de estas herramientas dificulta la detección de código malicioso, especialmente si está bien camuflado.

- El ataque puede propagarse rápidamente en proyectos colaborativos, donde múltiples desarrolladores utilizan la misma herramienta.

Además, este vector de ataque resalta la importancia de implementar medidas de seguridad robustas en la cadena de suministro de software, incluyendo la verificación de integridad de los archivos de configuración y la adopción de prácticas como la firma digital de código.

Medidas de mitigación

Para reducir el riesgo de ser víctima de un ataque Rules File Backdoor, se recomienda:

- Revisar y validar manualmente el código generado por herramientas de IA antes de integrarlo en proyectos críticos.

- Implementar herramientas de análisis estático y dinámico para detectar comportamientos sospechosos en el código.

- Restringir el uso de archivos de configuración externos y asegurarse de que provengan de fuentes confiables.

- Mantener actualizadas las herramientas de desarrollo y aplicar parches de seguridad tan pronto como estén disponibles.

Conclusión

El descubrimiento del ataque Rules File Backdoor subraya los desafíos emergentes en la seguridad de las herramientas de desarrollo basadas en IA. A medida que estas tecnologías se vuelven más populares, es crucial que los desarrolladores y las organizaciones adopten un enfoque proactivo para garantizar la integridad y seguridad del código generado. La combinación de revisiones manuales, herramientas de análisis automatizado y mejores prácticas de seguridad será clave para mitigar este tipo de amenazas.

Para más detalles sobre este tema, consulta la fuente original.